L’intelligenza artificiale (AI) può essere addestrata a riconoscere se l’immagine di un tessuto contiene un tumore.

Tuttavia, come prende esattamente la sua decisione è rimasto un mistero fino ad ora. Un team del Centro di ricerca per la diagnostica proteica (PRODI) della Ruhr-Universität Bochum, in Germania, sta sviluppando un nuovo approccio che renderà la decisione di un’IA trasparente e quindi affidabile. I ricercatori guidati dal professor Axel Mosig descrivono l’approccio sulla rivista Medical Image Analysis , pubblicata online nell’ agosto 2022.

Per questo studio, lo scienziato di bioinformatica Axel Mosig ha collaborato con il professor Andrea Tannapfel, capo dell’Istituto di patologia, l’oncologo professor Anke Reinacher-Schick dell’ospedale St. Josef della Ruhr-Universität e il biofisico e direttore fondatore dell’Istituto Prodi, centro per la diagnostica proteica, il professor Klaus Gerwert. Il gruppo ha sviluppato una rete neurale, ovvero un’IA, in grado di classificare se un campione di tessuto contiene o meno un tumore. A tal fine, hanno fornito all’IA un gran numero di immagini microscopiche di tessuti, alcune delle quali contenevano tumori, mentre altre erano esenti da tumore.

“Le reti neurali sono inizialmente una scatola nera: non è chiaro quali caratteristiche di identificazione una rete apprenda dai dati di addestramento”, spiega Axel Mosig.

A differenza degli esperti umani, non hanno la capacità di spiegare le loro decisioni. “Tuttavia, per le applicazioni mediche in particolare, è importante che l’IA sia in grado di fornire spiegazioni e quindi sia affidabile”, aggiunge il ricercatore di bioinformatica David Schuhmacher, che ha collaborato allo studio.

L’IA spiegabile del team di Bochum si basa quindi sull’unico tipo di affermazioni significative conosciute dalla scienza: su ipotesi falsificabili. Se un’ipotesi è falsa, questo fatto deve essere dimostrabile attraverso un esperimento. L’intelligenza artificiale segue solitamente il principio del ragionamento induttivo: utilizzando osservazioni concrete, ovvero i dati di addestramento, l’IA crea un modello generale sulla base del quale valuta tutte le ulteriori osservazioni.

Il problema di fondo era stato descritto dal filosofo David Hume 250 anni fa e può essere facilmente illustrato: non importa quanti cigni bianchi osserviamo, non potremmo mai concludere da questi dati che tutti i cigni sono bianchi e che non esistono cigni neri di sorta. La scienza si avvale quindi della cosiddetta logica deduttiva. In questo approccio, un’ipotesi generale è il punto di partenza. Ad esempio, l’ipotesi che tutti i cigni siano bianchi viene falsificata quando viene individuato un cigno nero.

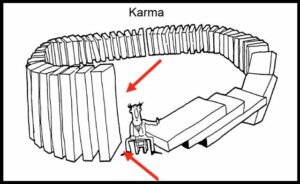

La mappa di attivazione mostra dove viene rilevato il tumore

“A prima vista, l’IA induttiva e il metodo scientifico deduttivo sembrano quasi incompatibili”, afferma Stephanie Schörner, fisica che ha anche contribuito allo studio. Ma i ricercatori hanno trovato un modo. La loro nuova rete neurale non solo fornisce una classificazione per stabilire se un campione di tessuto contiene un tumore o è privo di tumore, ma genera anche una mappa di attivazione dell’immagine microscopica del tessuto.

La mappa di attivazione si basa su un’ipotesi falsificabile, ovvero che l’attivazione derivata dalla rete neurale corrisponda esattamente alle regioni tumorali presenti nel campione. Metodi molecolari sito-specifici possono essere utilizzati per verificare questa ipotesi.

“Grazie alle strutture interdisciplinari di PRODI, abbiamo i migliori prerequisiti per incorporare l’approccio basato su ipotesi nello sviluppo di un’IA affidabile di biomarcatori in futuro, ad esempio per essere in grado di distinguere tra determinati sottotipi tumorali rilevanti per la terapia”, conclude Axel Mosig.